È l’anno dell’intelligenza artificiale. Col 2023 siamo entrati nel “momentum” in cui le varie forme di A.I. sono diventate pop e mainstream, non più come argomento per specialisti, geek e attenti al mondo tecnologico, ma come tema per editoriali, articoli di costume, concreto impatto sulla nostra vita.

E le Istituzioni si muovono sull’argomento. Come rilevato dal Mit Technology Rewiev, vedremo il panorama normativo dell’IA passare da linee guida etiche vaghe e generali a normative concrete. I legislatori dell’Unione Europea nell’UE stanno finalizzando una serie di norme, e anche le agenzie governative statunitensi come la Federal Trade Commission elaborano nuove coordinate giuridiche.

I legislatori in Europa stanno lavorando a regole per i modelli di intelligenza artificiale generativa che producono immagini e testo, come ad esempio Stable Diffusion, LaMDA e ChatGPT. Regole che potrebbero segnare la fine dell’era delle aziende che rilasciano i loro modelli di intelligenza artificiale in totale libertà, o con poca (o nessuna) protezione o responsabilità.

I modelli a menzionati costituiscono sempre più la spina dorsale di molte applicazioni di intelligenza artificiale, eppure le aziende che li realizzano restano “abbottonate” su come queste applicazioni vengono costruite e addestrate. Di fatto non sappiamo molto su come funzionano, e questo rende difficile capire come i modelli generino contenuti dannosi o risultati distorti, e meno che mai come mitigare questi problemi.

L’Unione Europea sta pianificando di aggiornare il suo prossimo regolamento sull’intelligenza artificiale, chiamato A.I. Act, con regole che costringono le aziende a fare luce sul funzionamento interno dei loro modelli di intelligenza artificiale. Il regolamento sarà probabilmente approvato nella seconda metà dell’anno e, successivamente, le aziende dovranno conformarsi se vogliono vendere o utilizzare prodotti di intelligenza artificiale nell’UE o incorrere in multe fino al 6% del loro fatturato annuo totale mondiale.

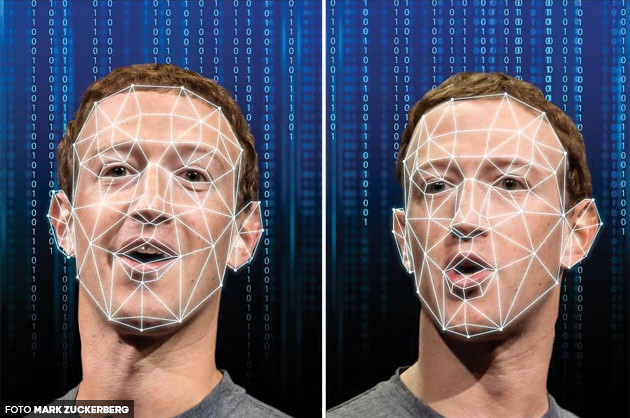

L’UE chiama questi modelli generativi “sistemi di intelligenza artificiale generica”, perché possono essere utilizzati per molte cose diverse (da non confondere con l’intelligenza generale artificiale). Ad esempio, modelli di linguaggio di grandi dimensioni come GPT-3 possono essere utilizzati nelle chatbot del servizio clienti o per creare disinformazione su larga scala, Stable Diffusion può essere utilizzato per creare immagini per biglietti di auguri o porno deepfake non consensuale.

«Mentre il modo esatto in cui questi modelli saranno regolati nell’AI Act è ancora oggetto di accesi dibattiti, i creatori di modelli di intelligenza artificiale generici, come OpenAI, Google e DeepMind, dovranno probabilmente essere più aperti su come sono costruiti e addestrati i loro modelli» afferma Dragoș Tudorache, membro del Parlamento europeo che fa parte del team che sta lavorando alla legge sull’IA.

Regolamentare queste tecnologie è complicato, perché ci sono due diverse serie di problemi associati ai modelli generativi, con soluzioni politiche molto diverse, afferma Alex Engler, ricercatore di governance dell’IA presso la Brookings Institution. Uno è la diffusione di contenuti dannosi generati dall’intelligenza artificiale, come l’incitamento all’odio e la pornografia non consensuale, e l’altro è la prospettiva di risultati distorti quando le aziende integrano questi modelli di intelligenza artificiale nei processi di assunzione o li utilizzano per esaminare documenti legali.

Engler suggerisce che i creatori di modelli generativi dovrebbero essere tenuti a creare restrizioni su ciò che i modelli produrranno, monitorare i loro risultati e bloccare gli utenti che abusano della tecnologia.

L’attuale spinta da parte delle autorità di regolamentazione per una maggiore trasparenza e responsabilità aziendale potrebbe inaugurare una nuova era in cui lo sviluppo dell’IA è meno sfruttatore e viene fatto in modo da rispettare diritti come la privacy.